La fiducia nell’uomo è una domanda cruciale, soprattutto quando si tratta di una tecnologia potente e pervasiva come l’intelligenza artificiale (IA). L’umanità ha una storia complessa, fatta di innovazioni straordinarie ma anche di errori e decisioni discutibili.Ecco la buona notizia: non mancano gli sforzi per creare principi etici condivisi. Diverse organizzazioni e governi stanno sviluppando linee guida per garantire che l’IA sia utilizzata in modo responsabile. Parole chiave come trasparenza, giustizia e responsabilità sono al centro di queste discussioni.

Ad esempio, l’Unione Europea sta lavorando all’AI Act, una legge che mira a classificare i sistemi di IA in base al loro livello di rischio. Le applicazioni meno pericolose, come i chatbot, avranno meno restrizioni, mentre quelle più sensibili, come il riconoscimento facciale, saranno sottoposte a regole più rigide.

Tuttavia, c’è un problema: l’IA è una tecnologia globale, ma le leggi sono spesso locali. Senza una cooperazione internazionale, c’è il rischio che paesi con poche regole diventino rifugi per lo sviluppo di tecnologie pericolose. Servono accordi tra nazioni, come quelli che abbiamo per l’energia nucleare o le emissioni di CO2.

L’Uomo come Creatore e Controllore

L’IA è uno strumento creato dall’uomo, e la sua utilità o pericolosità dipende dalle intenzioni e dalla competenza di chi la sviluppa e gestisce. Gli esseri umani hanno dimostrato di poter utilizzare tecnologie potenti sia per il progresso che per fini meno nobili. Pensa alla rivoluzione industriale: da una parte ha portato innovazione e benessere, dall’altra inquinamento e disuguaglianze.

La vera domanda non è se possiamo fidarci dell’uomo in assoluto, ma come possiamo progettare meccanismi che limitino gli abusi. Questo significa creare sistemi di governance, trasparenza e controllo.

L’Etica è Universale?

Non tutti gli uomini condividono gli stessi valori o principi etici. In ambiti come l’IA, questo è particolarmente problematico. Cosa succede se l’IA viene utilizzata da regimi autoritari per la sorveglianza di massa? Oppure da aziende per massimizzare i profitti a scapito della privacy degli utenti?

È qui che entra in gioco la necessità di regole globali. Organizzazioni come l’UNESCO stanno cercando di stabilire linee guida universali per lo sviluppo etico dell’IA, ma queste regole saranno efficaci solo se tutti i paesi e le aziende le adotteranno.

La Tendenza all’Errore

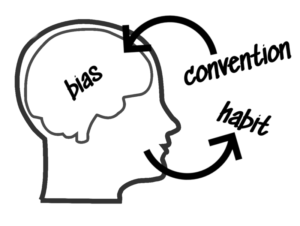

Gli esseri umani sono inclini all’errore, e questa fallibilità si riflette anche nei sistemi di IA che progettano. Bias nei dati, errori di programmazione e decisioni affrettate possono portare a risultati inaspettati o pericolosi. Ad esempio, algoritmi mal progettati possono perpetuare discriminazioni o prendere decisioni non trasparenti.

Per mitigare questi rischi, serve una supervisione continua, sia tecnica che etica. Gli audit algoritmici e la partecipazione di esperti interdisciplinari (ingegneri, sociologi, filosofi) sono strumenti indispensabili.

L’Uomo Può Essere Superato?

Alcuni studiosi ritengono che, paradossalmente, una soluzione ai limiti umani potrebbe essere affidarsi all’IA stessa per il controllo dell’IA. Sistemi avanzati potrebbero monitorare le azioni umane e intervenire in caso di comportamenti non etici. Tuttavia, questa visione solleva altre domande: possiamo fidarci di una “macchina supervisore”? Chi programmerà questa macchina e con quali obiettivi?

Educare e Coinvolgere

Infine, non dobbiamo dimenticare che anche noi, come cittadini, abbiamo un ruolo. È facile pensare che siano solo governi e aziende a dover decidere, ma la verità è che le nostre scelte quotidiane contano. Quando accettiamo un’app senza leggere le condizioni o ignoriamo i rischi della sorveglianza, diamo implicitamente il permesso a un certo tipo di sviluppo tecnologico.

La società civile deve essere coinvolta in queste discussioni. Più siamo consapevoli dei rischi e dei benefici dell’IA, più possiamo chiedere trasparenza e regolamentazioni adeguate.

L’intelligenza artificiale ha il potenziale per migliorare la nostra vita, ma solo se viene sviluppata e utilizzata con responsabilità. Le sfide etiche e regolamentari non sono un ostacolo al progresso, ma una condizione necessaria per far sì che il progresso sia sostenibile e giusto.

La vera domanda non è solo cosa l’IA può fare, ma cosa vogliamo che faccia. E questa è una scelta che spetta a tutti noi.

Se la fiducia nell’uomo è limitata, la soluzione non è rinunciare al progresso, ma educare e responsabilizzare le persone coinvolte. Una società informata può chiedere trasparenza e partecipare alle decisioni che riguardano l’IA. Coinvolgere cittadini, governi, e aziende in un dialogo aperto è essenziale per costruire fiducia.

Fidarsi dell’uomo non significa ignorarne i limiti, ma riconoscerli e lavorare per superarli. La fiducia cieca è pericolosa, ma anche il cinismo lo è: rinunciare alla possibilità di migliorare porta solo stagnazione. La sfida sta nel bilanciare innovazione e responsabilità, costruendo meccanismi che ci aiutino a prendere decisioni sagge, nonostante le nostre imperfezioni.

Tu cosa ne pensi? La fiducia nell’uomo è una speranza realistica o un rischio calcolato?

L’intelligenza artificiale (IA) è una delle tecnologie più rivoluzionarie del nostro tempo. Dalle auto autonome ai sistemi di raccomandazione, dai chatbot alle diagnosi mediche, l’IA sta trasformando ogni aspetto della società, portando con sé opportunità incredibili e sfide importanti.

L’intelligenza artificiale (IA) è una delle tecnologie più rivoluzionarie del nostro tempo. Dalle auto autonome ai sistemi di raccomandazione, dai chatbot alle diagnosi mediche, l’IA sta trasformando ogni aspetto della società, portando con sé opportunità incredibili e sfide importanti.